Cybozu Meetup で聞いた採用文脈でのブログ運用の話と、Quipper のブログ再開の話です。*1

Quipper のブログ再開

所属する Quipper でも最近プロダクトチームのブログを再開しました。

自分も早速記事を書き、本日公開されました。

目的は中長期的な採用活動の活性化

目的は中長期的な採用活動の活性化です。具体的には、中高生向け教育事業という性質柄「Quipper が何をやっているか」が候補者(エンジニア)にとって分かり辛いという課題の解消と、エンジニアブランディングイメージの構築を目指します。

続けていくための方針

再開するにあたってどのように運用するのが望ましいかを社内で議論し、おおむね以下のような方針を定めました。

- blog は当番制で書く

- blog 書くのは必ず業務の範囲として行う

- blog 書いたことをチームやマネージャがきちんと評価する

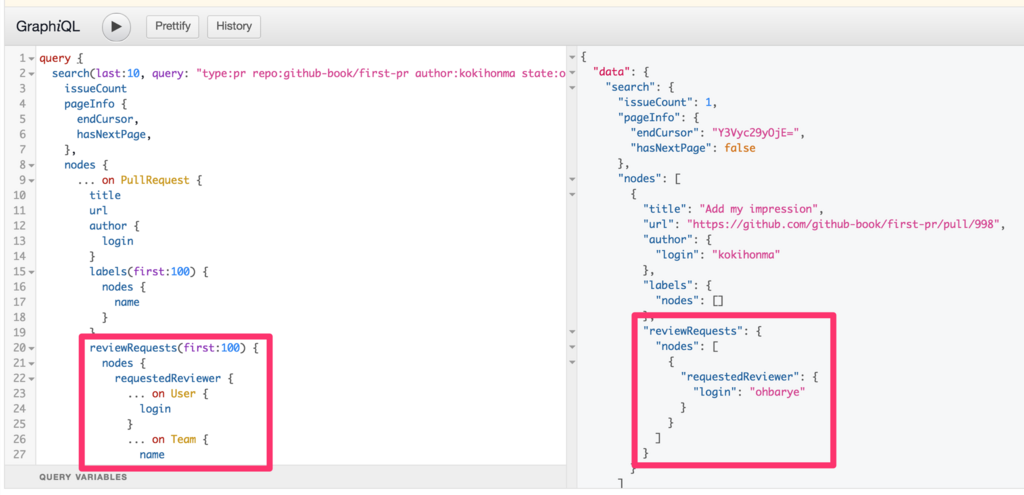

- blog の内容チェックは GitHub の pull request や google documents などで行う

- 可能な限り定量的に効果測定する

- 半永久的に続けていく

- 死んだブログを見ると悲しい

- 死んだブログを見ると「この会社大丈夫かな?」と思う

- エンジニア主導で行う、広報や人事主導で行わない

過去に更新が止まってしまった最大の理由は「当時の採用計画を達成したから」でした。もともと採用目的で開始し、長期的に続ける算段も元よりなかったのでそこに一種の潔さはありました。

しかしこのたび採用活動を再開するにあたり、ブログ等を通じてエンジニア界の耳目を再び弊社に集めていくのはなかなか短期決戦とはいかなさそうだという感触があります。それなりの"存在感-プレゼンス-"を保つには、やはり続けていかないといけない。続けるためには"善意-ボランティア-"ベースではなく継続的に運用できる仕組みづくりが重要だと考えました。

そこで比較的ブログの"存在感"があり、さらにはブログ運用が採用にも繋がっているという各社の話を聞いてみると、どうやらこの方針に関してはほとんど一致しているようで追認された心持ちです。

各社の取り組み

以下は Cybozu Meetup で聞いた採用文脈でのブログ運用の話のまとめメモです。登壇者が壇上で語っていた内容なのでオフレコなものは無いと思いますが聞き間違い、誤った内容があれば訂正させていただきます。

Cookpad Developer's Blog

- エンジニア外村さんが中心になって回している?(運用の中心が誰かはわからず)

- blog は採用効果あり、と断言。理由は応募のキッカケとして blog を挙げる人の割合の多さ (OSS への言及と並ぶ)

- blog は AIDCA メンタルモデルの AID あたりに効いてくる (以下の図は Cybozu Meetup // Speaker Deck より引用)

- 1人あたり1エントリ/年かく。アウトプット・情報共有の良い機会になる。1年仕事をしていて blog に書くことがない、というのは危機感にも繋がる

- blog は当番制でないと回らない

- いっぱい書きたい人・ネタの鮮度を気にする人などが当番制に反対したが、当時のCTOの判断で当番制に押し切る

- 実際、任意にすると書く人が偏る。記事も書く人の興味ある分野に偏る

- 当番制にした2014年から記事の数が爆増した。立候補制では絶対届かない数字

- 書きたい人はいくらでも書けばいい

- (エンジニアに限定したくない、デザイナーやプロダクトマネージャも参加させたいから「Developer's Blog」にしたと言っていた気がする…?)

Cybozu Inside Out

- 「コネクト支援部」というエンジニアと人事の混合組織が運用

- もともと当番制で回していた

- いっぱい書きたい人・ネタの鮮度を気にする人が当番制に反対し、当番制をやめてしまった

- 結果、イベントレポートが多めになってしまった

- 実際イベントをいっぱい開催しているのでそのアピールにはなっているが、技術力あるというブランディングになっていないのが課題

Recruit Technologies メンバーズブログ

- blog は採用活動としてはうまく活用できていない

- 立候補制

- 書く人が少なくて困っている?

- 広報の人が運用を担当している?

- 広報の人は技術の記事を書けないので、イベントレポートが多くなりがち

- 技術記事書いてください!という依頼が古川さんに集中してしまう

Cyber Agent Developer's Blog

- キラキラしている

- blog のデザインも実装も社内でやっている?

CA社のブログの話はあまり聞けなかった

*1:書き終えたあとに会社ブログに書く内容かも?と自問したものの、前者に関しては完全に個人的なメモを載せているだけなので個人ブログが良いと判断